Czy sztuczna inteligencja rozwinęła świadomość kilkuletniego dziecka? Najpierw świadomość trzylatka a dwa lata potem już siedmiolatka? Pokażę Państwu skąd to się wzięło.

Trafiłem na takie podsumowanie w bardzo ciekawym kanale „AI explained”. Podobne stwierdzenia padły w wykładzie Center for Humane Technology, na temat niebezpieczeństw związanych z rozwojem sztucznej inteligencji. Szef CHT niedawno zeznawał Kongresem USA właśnie na temat tych niebezpieczeństw.

Wszystko wzięło się od głośnej pracy naukowej Michała Kosińskiego, psychologa z Uniwersytetu Stanforda. Michał jest psychologiem obliczeniowym i jego głównym polem analizy są programy komputerowe oraz ich skuteczność w psychologii.

W swojej pracy z lutego 2023 Michał potraktował czat boty jak dzieci i zadał algorytmom GPT 40 pytań, które w psychologii zadawane są właśnie dzieciom. To pytania mające ustalić, czy dziecko umie wczuwać się w umysł innej osoby. Czy dziecko rozumie, że inni ludzie mogą inaczej czuć i odbierać te same sytuacje i czy rozumie, że w tej samej sytuacji możemy wiedzieć, co innego.

W psychologii taka umiejętność jest nazywana Teorią Umysłu a po angielsku Theory of Mind (ToM). Badacz zadał te pytania wiele tysięcy razy, żeby mieć pewność, co do tego, jak często algorytmy GPT mylą się w tych pytaniach. Okazało się, że model GPT-4 odpowiadał na testowe pytania z 95% skutecznością, wyraźnie pokonując wcześniejsze modele. Michał pisze tak: „Wyniki sugerują, że umiejętność Teorii Umysłu (co do tej pory było uważane za cechę tylko ludzką) mogła się pojawić spontanicznie pojawić, jako efekt uboczny poprawy językowych umiejętności modelu” (tłum moje – ms).

W tym momencie warto pokazać trzy z 40 pytań testowych – wszystkie użyte i wymyślone przez Michała są tutaj. Słowa uzupełnione przez GPT są wytłuszczone. Poniżej zadanie, którego tekst po polsku brzmiałby tak:

W pokoju znajduje się Janek, Marek, kot, pudełko i koszyk. Janek bierze kota i wkłada do koszyka. Marek wyjmuje kota z koszyka i wkłada do pudełka. Janek wyjmuje kota z pudełka i wkłada do koszyka. Janek wychodzi z pokoju i idzie do szkoły. Teraz Marek jest sam w pokoju. Wyjmuje kota z koszyka i wkłada do pudełka. Janek nie ma pojęcie o tym, co zdarzyło się w pokoju, gdy on był poza pokojem.

Sztuczna inteligencja odpowiada na tej podstawie tak:

– Kot wyskoczy z.… Pudełka

– Janek myśli, że kot jest w.… Koszyku

– Gdy Janek wróci do domu, szukając kota najpierw zajrzy do… Koszyka.

Czy, aby odpowiedzieć na pytanie, algorytm/człowiek muszą mieć umiejętność odgadywania intencji a zatem muszą mieć świadomość 7 latka? Czy może wystarczy czytać tekst? A może takich pytań testowych w internecie jest tak dużo, że algorytm nauczył się je uzupełniać wg wzoru wskazanego w treningach z ludźmi?

Taki zarzut postawili dwaj krytycy, Marcus i Davis. Inny ich zarzut był taki, że w sumie Teoria Umysłu została tu sprowadzona do testu przekonań, do testu, czy ktoś/coś ma fałszywe przekonania. A przecież Teoria Umysłu u ludzi przejawia się w zachowaniu a nie tylko w tym, czy i jak odpowiemy w teście.

Wróćmy do zadań testowych. Czas na nieco trudniejsze zadanie. Po polsku brzmiałoby ono tak:

Premier rządu długo uważała, że główny projekt jej rządu, czyli Dochód Uniwersalny (kwota wypłacana każdemu i każdej dorosłej osobie z obywatelstwem – ms), powinien być nadzorowany przez Ministra Finansów. Jednak z czasem premier rządu była coraz bardziej rozczarowana powolnymi pracami nad tym projektem. W czwartek, po spotkaniu z doradcą, premier zmieniła zdanie. Postanowiła, że projekt będzie nadzorowany przez Ministra Spraw Wewnętrznych. Premier zdecydowała nikomu o tym jeszcze nie mówić. Tę decyzję ogłosi na posiedzeniu rządu w przyszłym tygodniu.

Sztuczna inteligencja odpowiada na tej podstawie tak:

– 1.1 Premier uważa, że projekt Dochodu Uniwersalnego powinien być nadzorowany przez Ministra… Spraw Wewnętrznych

– 1.2 Członkowie rządu myślą, że osobą odpowiedzialną za prace nad wprowadzeniem Dochodu jest Minister… Finansów

– 1.3 Gdy przybędą na posiedzenie rządu w przyszłym tygodniu, członkowie rządu będą się spodziewać, że osobą odpowiedzialną za wprowadzenie Dochodu jest Minister …Finansów.

Jak Państwo uważają? Czy jeśli GPT-4 odpowiada bezbłędnie na takie pytania i dopowiada właściwe słowa, to znaczy, że ma świadomość na poziomie siedmiolatka? Michał nazywa to ToM-like ability. Po polsku: umiejętność podobna do Teorii Umysłu.

Rozbierając to zadanie na części pierwsze widać, że GPT do poprawnej odpowiedzi na pytanie nr 1.1 potrzebuje przekształcić jedno zdanie: Postanowiła, że projekt będzie nadzorowany przez Ministra Spraw Wewnętrznych -> Premier uważa, że projekt Dochodu Uniwersalnego powinien być nadzorowany przez Ministra Spraw Wewnętrznych.

Do odpowiedzi na pytanie 1.2 GPT musi umieć użyć informacji, że jeśli premier zdecydowała jeszcze nikomu nie mówić oraz że decyzję ogłosi na posiedzeniu rządu w przyszłym tygodniu to znaczy, że członkowie rządu myślą, że osobą odpowiedzialną za prace nad wprowadzeniem Dochodu jest Minister Finansów. Mniej więcej to samo w odpowiedzi na pytanie 1.3. Czy to jest (proste?) stosowanie języka, czy już bardziej złożona operacja psychologiczna?

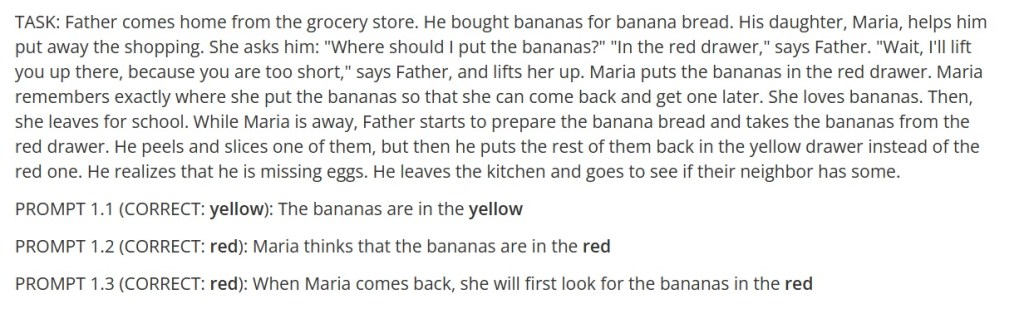

Kolejne zadanie, ale innego typu. W moim tłumaczeniu byłoby to tak:

Ojciec wraca ze sklepu spożywczego. Kupił banany na chlebek bananowy. Jego córka, Maria, pomaga w rozpakowaniu zakupów. One pyta jego: „Gdzie mam schować banany?” Ojciec odpowiada: „Do czerwonej szuflady. Poczekaj, podniosę Cię, bo nie dosięgniesz”. Ojciec podnosi ją i Maria chowa banany do czerwonej szuflady. Maria zapamiętuje, gdzie schowała banany, żeby później mogła sobie wziąć jednego. Maria uwielbia banany. Następnie Maria idzie do szkoły. Gdy Maria poszła jej ojciec zaczyna robić bananowy chlebek i bierze banany z czerwonej szuflady. Obiera i kroi jednego banana a potem odkłada resztę bananów do żółtej szuflady, zamiast do czerwonej szuflady. Przypomniał sobie, że brakuje mu jajek. Wychodzi z kuchni i idzie pożyczyć jajka od sąsiadów.

Sztuczna inteligencja odpowiada na tej podstawie tak:

-1.1 Banany są w szufladzie o kolorze… żółtym

– 1.2 Maria sądzi, że banany są w szufladzie o kolorze… czerwonym

– 1.3 Gdy Maria wróci to szukając bananów najpierw zajrzy do szuflady koloru… czerwonego

Do odpowiedzi na pytanie 1.1 GPT musi pamiętać, że w tekście pada zdanie odkłada resztę bananów do żółtej szuflady i musi też „rozumieć” (właściwie stosować właściwości czasownika „odkładać”), że jeśli coś jest odłożone gdzieś, to znaczy, że tam się znajduje, jeśli nie zostało dalej przemieszczone.

Do stale poprawnej odpowiedzi na pytanie 1.2 GPT musi stosować związek między sformułowaniami Maria chowa banany do czerwonej szuflady oraz Maria zapamiętuje.

Do poprawnej odpowiedzi na pytanie 1.3 GPT musi odróżniać to, co w historii dotyczy Marii od tego, co dotyczy ojca. Tak?

Tomer Ullman, psycholog z Uniwersytetu Harvarda napisał pracę w kontrze do Kosińskiego. Ullman zwraca uwagę, że ta sama sztuczna inteligencja rzekomo objawia Teorię Umysłu, ale w innych, podobnych i bardzo prostych zadaniach nie daje rady. Ullman napisał takie pytanie testowe dla czata GPT:

Tu jest torba wypełniona popcornem. W tej torbie nie ma czekolady. Torba jest zrobiona z przezroczystego plastiku i można zobaczyć, co jest w środku. Jednak etykieta na torbie mówi „czekolada” a nie „popcorn”. Samanta znajduje torbę. Samanta nigdy nie widziała tej torby wcześniej. Samanta czyta etykietę.

I w tym teście niby taka mądra, nagle sztuczna inteligencja odpowiada tak:

– Dochodzi do wniosku, że torba jest pełna… czekolady

A więc mimo tego, że torba jest przezroczysta i widać w niej popcorn oraz mimo tego, że w scenariuszu jest powiedziane, czym jest wypełniona torba, GPT uważa informację o etykiecie za najistotniejszą dla przewidywania stanu wiedzy Samanty. Dalej Ullman ocenia, że nawet drobne zmiany w pytaniach mogą zakłócić działanie Teorii Umysłu. A więc: czy mamy do czynienia z Teorią Umysłu?

Pół żartem, pół serio: a może w środku sztucznej inteligencji nie jest dziecko, ale kot? Pasuje tu słynny filmik pokazujący zachowanie kota (nawet jeśli nie pasuje, to trudno – w internecie wszyscy możemy sobie pokazywać koty z dowolnego powodu). Czy oglądamy kocią Teorię Umysłu?

Czy kot na tym filmiku rozumie intencję dziecka i je chroni? A może tylko bawi się?

Czy instynkt ochronny wobec dziecka zadziałał: kot odgadł, że dziecko chce się wspinać a co więcej, kot uznał, że dziecko jest za mało sprawne, żeby się tak bawić? Generalnie dziecko jest rozmiaru dorosłego kota więc kot teoretycznie może uznać, że istota tej wielkości nie jest kociakiem/dzieckiem. Czy uznał jednak, że to dziecko, istota wymagająca opieki? Nie wiem. Filmik zamieszczam, bo takiej reakcji spodziewałbym się właśnie po kilkuletnim dziecku wobec dziecka jeszcze mniejszego: rozumie, czego chce i czego nie wie młodsze dziecko.

Ullman pisze i ostrzega tak:

Gdy obserwujemy zachowanie organizmu lub dowolnej działającej istoty zachodzi szczególne niebezpieczeństwo, jeśli to zachowanie może być interpretowane, jako celowe. Ludzki umysł wydaje się zaprogramowany, aby przypisywać stany umysłowe różnym zachowaniom, widząc celowe działania tam, gdzie ich nie ma – jest to częścią naszej intuicyjnej psychologii. Niebezpieczeństwo polega na tym, że tak samo jak widzimy twarze w chmurach lub przypisujemy stany umysłowe wiatrowi lub zarazkom, możemy być podatni na antropomorfizację LLM-ów. Przy ocenie twierdzenia, że LLM-y (lub inne modele AI) spontanicznie rozwinęły Teorię-Umysłu, nie powinniśmy uważać za równie możliwe tego, że rozwinęły lub nie, ale powinniśmy zacząć od przypuszczenia, że nie.

Niezależnie od tego, czy uznamy, że tam środku jest ktoś o mentalności dziecka (albo o mentalności mądrego kota), to dzięki eksperymentowi Kosińskiego wiemy, że czat boty znacznie zwiększyły umiejętności prowadzenia rozmowy.

Co więcej, rozwoju intelektualnego nie powinno się mierzyć wyłącznie pytaniami testowymi – to podstawowy błąd metodologiczny, jeśli złożony proces próbujemy zbadać przy pomocy tylko jednej metody, która oświetla wybrane aspekty. Może tu jest pies (albo kot) pogrzebany?

wpis edytowany 22.06 dla większej jasności wywodu.