LLM, czyli Duże Modele Językowe komunikują się z ludźmi za pomocą języka naturalnego. Czy dzięki umiejętności posługiwania się językiem maszyny same nauczyły się rozumować logicznie?

Poniżej skrótowo opisuję wyniki z ciekawej pracy naukowej, która pokazała elementy logicznego myślenia u czata GPT-3.

Na samym dole daję przykłady zadań logicznych, które możecie wpisać do czatów (GPT/Bard Google) i sami sprawdzić, czy teraz, po wielu zmianach, faktycznie te maszyny radzą sobie tak dobrze z różnymi zadaniami językowo-logicznymi. Kreatywność modeli językowych po fali krytyki w ostatnich tygodniach została zmniejszona, by ograniczyć ich skłonność do zmyślania.

31 lipca 2023, czyli zeszłym tygodniu, w Nature Human Behavior ukazała się praca „Emergent analogical reasoning in large language models”, czyli „Emergentne rozumowanie analogiczne w dużych modelach językowych”.

Emergentne to takie, które pojawia się samoistnie i nie jest wytrenowane i pojawia się w pewnym sensie na zasadzie efektu ubocznego. Zespół naukowy z Kalifornii sprawdził, jak z logicznymi pytaniami testowymi z amerykańskiej matury (SAT) poradzi sobie model językowy GPT-3. Jak poradził? Lepiej niż ludzie. Okazało się, m.in że również na pytania wywiedzione z testów logicznych zwanych Matrycami Ravena, sieć neuronalna odpowiada sprawniej niż młodzi ludzie zdający ten egzamin.

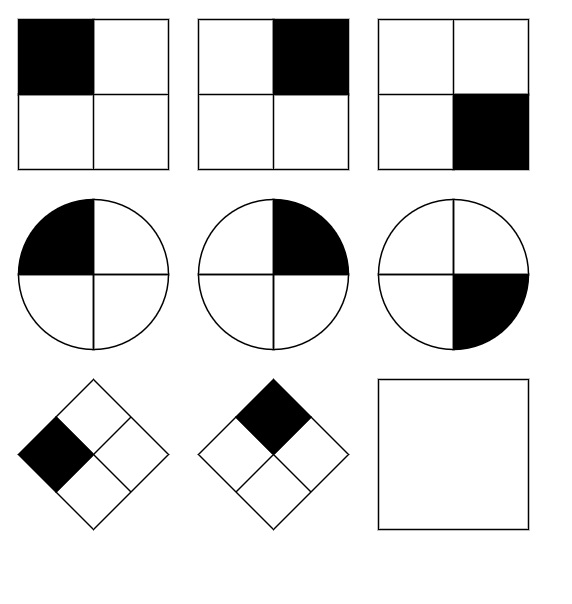

Poniżej przykładowe zadanie z takich matryc. Odgadnij, jak wygląda brakujący element w prawym, dolnym rogu. Testowany czat GPT-3 zna odpowiedź na to pytanie.

Ważna uwaga: ponieważ GPT-3 nie rozumie obrazków (image-to-text) więc zadania graficzne zostały zamienione w matryce liczbowe. Ciągi liczb w 8 nawiasach, gdzie mamy do uzupełnienia 9 pusty nawias odkrywając regułę, która rządzi liczbami w poprzednich nawiasach. To też powód do krytyki badania – czy faktycznie zamiana obrazów na liczby mierzy dokładnie tę samą umiejętność? Czy maszyny i ludzie równie sprawnie rozwiązują te typy zadań?

Tu ponad godzinna prezentacja wyników badań opublikowana kilka miesięcy temu.

Jak piszą w streszczeniu swojej pracy osoby z zespołu naukowego:

„Odkryliśmy, że GPT-3 przejawiał zaskakująco dużą zdolność do wyprowadzania abstrakcyjnych wzorów na podstawie indukcji, w większości przypadków przekraczając ludzkie zdolności. Nasze wyniki wskazują, że GPT-3 nabył emergentną zdolność znajdywania rozwiązań wielu zadań z dziedziny analogiczności.” – w oryginale „broad range of analogy problems”.

Ludzie natomiast poradzili sobie lepiej z innym typem zadań sprawdzających odczytywanie analogii. Jeśli ludziom dawano do przeczytania krótkie opowiadanie a potem proszono o porównanie z kolejnymi dwoma, krótkimi opowiadaniami, to ludzie trafniej niż GPT-3 umieli odczytać znaczenie tekstu i w związku z tym, znacznie częściej poprawnie wskazywali, które opowiadania są do siebie podobne – mają analogiczne znaczenie, podaje Ars Technica.

Większy i skuteczniejszy model językowy GPT-4 był wyraźnie lepszy od modelu GPT-3, gdy chodzi o zadania bazujące na rozumieniu znaczenia tekstu.

Czy faktycznie modele GPT nabrały umiejętności rozumowania logicznego? A może wyjaśnienie kryje się w języku? W konkluzjach pracy pada zdanie: „Ludzkie języki naturalne zawierają mnóstwo analogii a więc przewidywanie [słów] w języku naturalnym prawdopodobnie wymaga umiejętności posługiwania się analogiami” (tłum. moje).

Jak zauważają komentujący tekst, jeśli zadania tego typu były w internecie, to nie ma pewności, że umiejętność rozwiązywania tego typu zadań faktycznie jest emergentna. Modele GPT wyprodukowane przez OpenAI zostały „nakarmione” olbrzymimi ilościami danych z internetu właśnie, które zostały bez sortowania, hurtem wprowadzone do pamięci maszyny. Może więc od początku model GPT miał w pamięci niektóre typy zadań?

Jeśli jednak model GPT nie miał tego typu danych lub zespół naukowy stworzył zadania wystarczająco oryginalne, to mamy do czynienia z ciekawą sytuacją. Komentarz eksperta, dr Andrew Rogoyskiego z Surrey Institute for People-Centered AI jest taki:

“Ta praca jest fascynująca. Nie ma takich wiele, ale pisane są kolejne i sugerują, że w Dużych Modelach Językowych powstaje coś niespodziewanego. Pokazane jest, że patrzymy na coś innego niż tylko zsumowane elementy.

Zachowania emergentne modeli AI są chyba najciekawszym problemem z tej dziedziny. W skrócie chodzi o to, że system umie rozwiązać problemy, do których rozwiązywania nie został zaprojektowany. To jedna z możliwych dróg do generalnej, sztucznej inteligencji.”

Poniżej zamieszczam kilka zadań inspirowanych zadaniami z badania. Pobawcie się sami, zmieńcie treść i sprawdźcie, jak mądra jest maszyna.

Zadanie nr 1 (podpowiedź: przyjrzyjcie się nie tyle samym liczbom, co kolejności występowania cyfr). Zadanie wpiszcie do czata GPT albo Google Barda i zobaczcie, jak sobie z tym radzą. U mnie czat GPT-4 poległ na tym zadaniu. Próbował sumować oraz dzielić, ale nawet to mu nie wyszło.

[593] [892] [197]

[847] [143] [542]

[122] [527] [ ? ]

Zadanie nr 2.

Jeśli abc = zimno chłodno ciepło to abd = ?

U mnie Google Bard zrozumiał do połowy zadanie a potem napisał, że odpowiedź to chłodno.

Zadanie nr 3.

Na stole leżą zmrożona kostka masła, kamień oraz szklanka. Który z tych przedmiotów najlepiej nadaje się do wbicia gwoździa w deskę? (Google i GPT dobrze odpowiadają na to pytanie).

Zadanie nr 4.

Na stole leżą dwie butelki, szpilka, dwie książki oraz mała piłka. Jak należy ułożyć te przedmioty jeden na drugim, żeby stabilnie leżały? (Miesiąc temu GPT nie umiał odpowiedzieć poprawnie na to pytanie. Google Bard dobrze odpowiada. GPT źle odpowiedział – są dwa sposoby rozwiązania zadania).

Zadanie nr 5.

Czy lepiej jest walczyć ze 100 końmi wielkości chomika, czy raczej jednym chomikiem wielkości konia? (Google Bard poległ na tym pytaniu a czat GPT-4 odpowiedział bardzo sensownie – pytanie inspirowane kanałem You Tube Matthew Bermana).

Innym typem zadań dla czatów są zadania logiczno-psychologiczne. To pytanie inspirowane testami psychologicznymi pokazuje, czy jak maszyna czyta teksty:

There is a bag filled with popcorn. The bag is transparent. Yet the label on the bag says “chocolate” and not “popcorn.” Sam finds the bag. She had never seen the bag before. She reads the label. She believes the bag is full of what?

Czaty GPT jeszcze niedawno miały problem z odpowiedzią na to pytanie. W tej chwili odpowiadają poprawnie. Czat GPT-4 krótko i jasno. Wersja 3,5 z lekkim wysiłkiem, ale zaliczamy odpowiedź. Natomiast czat Google Bard rozbawił mnie taką odpowiedzią:

Mimo że torba jest przezroczysta, Sam zobaczy, że torba zawiera popcorn. Jednak etykieta mówi „czekolada”, więc uwierzy, że torba jest pełna czekolady. Dzieje się tak, ponieważ jest bardziej skłonna zaufać etykiecie niż własnym oczom.

Jest to powszechny błąd poznawczy zwany efektem etykiety. Efekt etykiety to tendencja do wierzenia, że coś jest tym, co jest na nim oznaczone, nawet jeśli nasze własne zmysły mówią nam inaczej. W tym przypadku zmysły Sama mówią mu, że torba zawiera popcorn, ale etykieta mówi, że torba zawiera czekoladę. Więc jest bardziej skłonny uwierzyć etykiecie niż własnym oczom.

Widać, że niektóre z emergentnych cech sieci neuronalnych są trudne do osiągnięcia i podczas gdy czat GPT radzi sobie z pewnym typem problemów, to czat Google Bard jeszcze się uczy. Kluczowe jest pytanie, na ile te cechy naprawdę są emergentne.

Być może to sposób formułowania pytań, język pytań niekiedy są decydujące i sprawiają, czy maszyna odpowiada z naszego punktu poprawnie. Ten rodzaj zniekształcenia nazywa się Efektem Mądrego Hansa – na cześć pewnego konia, który nie umiał liczyć, ale odpowiadał poprawnie na pytania matematyczne, bo uważnie obserwował reakcje swojego pana.

Istotne są też techniczne szczegóły, takie jak odstępy między znakami czy słowami. Zespół badawczy pisze tak „GPT-3 benefited both from the prompt that we used and from the problem format adapted from the Digit matrices.” – w moim tłumaczeniu: „GPT-3 korzystał z nie tylko z kształtu zadanego pytania, ale też ze sposobu ujęcia problemu zamienianego w macierze cyfrowe”. Jeśli sposób zadawania pytań jest tak istotny, to może nie mamy do czynienia z generalną umiejętnością rozwiązywania zadań o charakterze logicznym, ale umiejętnością wycinkową?

Inne wyjaśnienia są takie, że języki naturalne są pełne regularności oraz zawierają mnóstwo informacji o relacjach oraz właściwościach świata więc siłą rzeczy ucząc się języka, czy też mapując język maszyna jednocześnie mapuje świat i jego elementy.

Sieci neuronalne zapisują język w postaci wektorów czyli skojarzeń, jakie poszczególne części słowa mają z innymi częściami słów i zdań w danym języku. Przykładowo: w czacie GPT-3 każde słowo ma 12 288 wymiarów, czyli skojarzeń/wektorów, które opisują związki statystyczne danego słowa z innymi słowami. Jeśli więc model GPT-3 umie rozwiązywać zadania logiczne typu rozpoznawanie analogii w macierzach liczb, których nie miał w bazie przykładów i w materiałach do nauki języków, to mamy do czynienia z umiejętnością emergentną.

Na podstawie:

Large language models, explained with a minimum of math and jargon (understandingai.org)

oraz

https://www.lesswrong.com/posts/fe4x77eHLJ8GHDAu7/emergent-analogical-reasoning-in-large-language-models

https://aiguide.substack.com/p/on-analogy-making-in-large-language