Użycie sztucznej inteligencji może zakłócić proces wyborczy i debatę, może też służyć ochronie wartości demokracji. W tej chwili wiemy o użyciu AI na kilka sposobów we właśnie zakończonej kampanii polskiej wyborczej. To zarówno działania na większą skalę jak i skromne, jednorazowe.

Prawo i Sprawiedliwość miało użyć technologii mikrotargetowania, czyli na podstawie śladów cyfrowych ludzie zostali rozpoznani i przypisani do konkretnych powiatów. Następnie w mediach społecznościowych automatycznie wyświetliły im się reklamy wyborcze PiS, które pokazywały, co konkretnie dane powiaty zawdzięczają polityce rządu. Tak podaje m.in Money.pl.

W zalinkowanym tekście wypowiada się również posłanka Koalicji Obywatelskiej, która zapewnia, że oni również potrafią się posługiwać internetem (również mikrotargetują?). Do pewnego stopnia mikrotargetowanie wymaga posługiwania się inteligentnymi algorytmami, które odnajdują powiązania i wzory w zbiorach danych.

O skandalu i aferze moglibyśmy mówić, gdyby wyszło na jaw, że któraś z partii miała dostęp do danych osobowych, które powinny być chronione. Np. ktoś miał dostęp do danych państwowych i używał ich w kampanii wyborczej albo ktoś kupował na czarnym rynku nielegalne, wykradzione dane osobowe i krzyżował te dane ze zbiorami śladów cyfrowych.

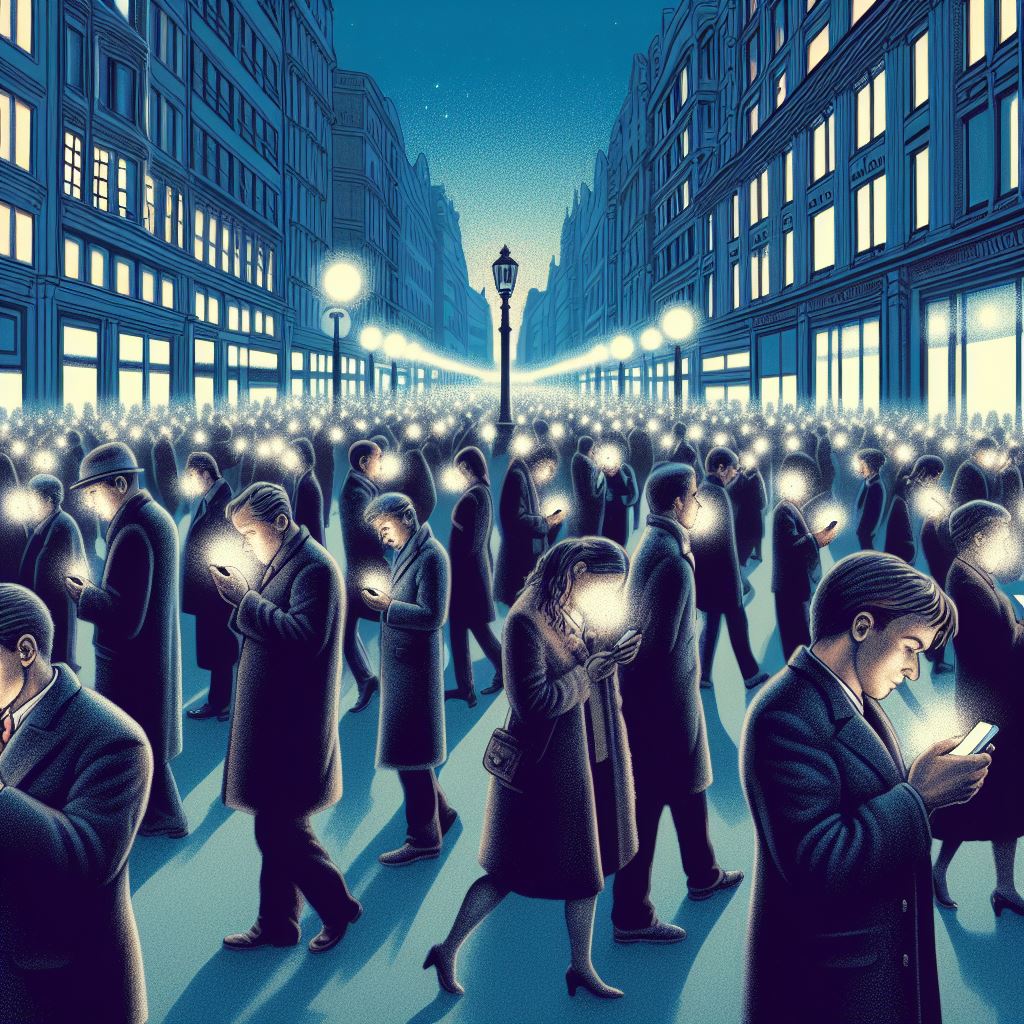

Najwyższą formą manipulacji z użyciem narzędzi AI byłaby hipotetyczna sytuacja, w której kampanię w internecie prowadziłyby algorytmy, automatycznie reagując na nowe dane. Algorytmy mikrotargetowałyby ludzi bombardując ich nie tylko deep-fejkowymi treściami, ale również wiadomościami pisanymi przez specjalne czatboty, których zadaniem byłoby skłonić ludzi do określonych zachowań: np. zwolenników utwierdzić w zamiarze głosowania lub wysłać do przekonywania niezdecydowanych a przeciwników zniechęcić do głosowania.

Gdyby jeszcze działo się to bez wyraźnego oznaczenia technik AI, czyli czatboty udawałyby ludzi a materiały komitetów udawałyby treści wiralowe, wtedy mielibyśmy do czynienia z wielką, algorytmową, inteligentną maszyną do manipulacji opiniami setek tysięcy ludzi na raz. To byłby koniec demokracji i przejście do nowego ustroju, w którym wygrywają lepsze algorytmy i większy budżet.

Tego się obawiamy i o tym pisze specjalny raport Unii Europejskiej. Prawo w tej chwili tego zabrania, ale zagrożenie jest realne, bo technologia już istnieje i do pewnego stopnia już jest stosowana tyle, że nie w polityce, ale w handlu internetowym – tam algorytmy monitorują ceny i wzajemnie się atakują w celu uzyskania przewagi rynkowej (patrz proces sądowy przeciw firmie Amazon założony przez FTC).

W kampanii wyborcze były też przypadki użycia sztucznej inteligencji generatywnej na skromną skalę. Wiemy, że KO wypuściła spot ze sklonowanym głosem Morawieckiego, który w tym spocie czytał prawdopodobnie swoje własne mejle. Wiemy też, że Suwerenna Polska wypuściła spot, który wyprodukowany w technologii text-to-video i animated pictures oskarżał opozycję o chęć sprowadzenia groźnych imigrantów.

Jak zauważa EFJ (Europejska Federacja Dziennikarska), użycie sklonowanych danych bez wyraźnego oznaczenia kwalifikuje się jako deep-fake, czyli technika manipulacji – spot KO. Deep-fake uważany jest najgroźniejszą formę manipulacji i dyskredytacji: działaniem, które poprzez podszywanie pod osobę ma pozbawić wiarygodności.

Filmik zamieszczony przez kandydata Suwerennej Polski, bez podania źródeł oraz kontekstu używał zdjęć niepokojów społecznych, oskarżając Tuska o chęć sprowadzenia migrantów. To nie był spot deep-fejkowy, choć użyto niestarannie sklonowanego wizerunku Tuska. Mieliśmy do czynienia z klasyczną manipulacją (insynuacją), do jakich niestety przywykliśmy, gdy chodzi o spoty wyborcze. Technologia sztucznej inteligencji została wykorzystana w tradycyjnie nieuczciwy sposób.

Możemy się domyślać, że sztaby pracowały wydajnie używając czatbotów, które pisały przekazy dnia, stanowiska, komentarze itd, które następnie ludzie wrzucali do mediów społecznościowych. Choć czatboty w tej chwili po polsku nie umieją się wypowiadać tak dobrze, jak robią to po angielsku, to jednak ich użycie znacznie przyśpiesza wykonanie zadań marketingowych czy reklamowych. Należy też założyć, że umiejętności w języku polskim z czasem będą się poprawiały i dojdziemy pomału do sytuacji, gdy czatboty będą pisać i mówić praktycznie jak ludzie.

Stąd wynikają postulaty, żeby wszystkie treści wytwarzane przez AI zawsze były oznaczane lub miały znaki wodne czy inne cechy pozwalające wykryć autorstwo. Ważne również, byśmy jako społeczeństwa, państwa i ludzie zaczęli bardzo poważnie traktować ochronę danych osobowych – w tym również danych, które chętnie udostępniamy w internecie.

To są dane, które często lekceważymy, „bo komu by się chciało mnie śledzić?” a przecież łatwo mogą zostać wykorzystane w celu zbudowania bazy, która daje możliwość automatycznego ataku, nacisku psychologicznego, który ponieważ jest prowadzony przez maszyny, może trwać non-stop, tak długo jak pozwala budżet. W rezultacie zamykałoby to nas w niewidzialnych bańkach, z których większość z nas się nie będzie umiała wyjść. A nawet jeśli wyszlibyśmy, to tylko po to, by ze zdumieniem i przerażeniem patrzeć, jak wszyscy wokół nas dają się manipulować.

Nie ma się co bać? To przecież niemożliwe? Dużo mniej futurystyczną wizję prezentuje słynny tekst z Scientific American, gdzie w lipcu 2023 autorzy zaproponowali eksperyment myślowy o tym, jak już teraz można użyć Facebooka czy innych mediów społecznościowych. Najważniejsza myśl tekstu jest taka, że w momencie użycia tej technologii rozpocznie się wielki wyścig zbrojeń. Jeśli jedna partia tego użyje, druga też musi. Celem walki będzie uzyskanie przewagi. Czasem wystarczy 3% i nagle żyjemy w zupełnie innej rzeczywistości.

To dlatego nowe, europejskie prawo o sztucznej inteligencji jest tak ważne. Akt o sztucznej inteligencji powinien być gotowy pod koniec roku. Zgodnie z nim używanie systemów AI zdolnych robić takie rzeczy byłoby mocno regulowane oraz poddane ścisłej kontroli.

A jak sztuczna inteligencja może pomóc w ochronie demokracji? Odpowiednio uregulowana może zwiększyć skuteczność edukacji obywatelskiej i edukacji w szkołach. Algorytmy mogą wykrywać akcje manipulacji, które umknęłyby ludzkiej uwadze. Manipulacja w przyszłości przecież może polegać na subtelnych działaniach ukierunkowanych na pobudzenie stanów emocjonalnych czy na ich wykrywaniu. Takie projekty są już prowadzone. Algorytmy najsłabszych mogą aktywnie chronić lub atakować. To, czy będą ich chronić jest kwestią decyzji. To, że będą atakować jest pewne – nieznana jest tylko skala zjawiska. Źli ludzie z innych krajów albo nawet z naszego będą chcieli użyć technologii AI. Już to robią.

Przyszłość już tu jest, tylko na razie nierówno dystrybuowana – jak mówi słynny cytat z Gibsona.

Na podstawie: https://www.europarl.europa.eu/RegData/etudes/BRIE/2023/751478/EPRS_BRI(20

23)751478_EN.pdf

https://www.scientificamerican.com/article/how-ai-could-take-over-elections-and-undermine-democracy/

https://counterhate.com/research/misinformation-on-bard-google-ai-chat/#about

https://politicaldictionary.com/words/astroturfing/