1 grudnia specjalna komisja brytyjskiej Izby Lordów opublikowała raport na temat zastosowań sztucznej inteligencji w systemach broni. Raport powstał w wyniku konsultacji eksperckich. Ma znamienny tytuł „Proceed with Caution: Artificial Intelligence in Weapon Systems”. Celem raportu jest wyjaśnienie i opisanie problemów związanych z użyciem sztucznej inteligencji w systemach uzbrojenia. Co ciekawe, ten raport dotyka wiele wątków obecnych również w polskich debatach na temat roli i zastosowań sztucznej inteligencji w wojsku (https://cyberdefence24.pl/technologie/wojsko-uzywa-sztucznej-inteligencji-jest-juz-na-wojnie). Ranga tego brytyjskiego raportu jest jednak większa niż nasze polskie rozmowy i debaty, gdyż Wielka Brytania produkuje bardziej zaawansowane systemy uzbrojenia niż Polska.

Raport m.in postuluje, by rząd Wielkiej Brytanii zaczął monitorować wydatki na tego typu sztuczną inteligencję oraz powstały metody oceny i nadzoru technologii sztucznej inteligencji. Jako ograniczenie raport wskazuje ograniczenia płacowe, czyli to, że wysoko wykwalifikowanym osobom, które umieją tworzyć technologie sztucznej inteligencji resort obrony może zapłacić najwyżej połowę tego, ile płaci sektor komercyjny. Raport zauważa także, że plany obrony kraju muszą uwzględniać możliwość użycia sztucznej inteligencji przez przeciwników.

Zgodnie z przyjętą przez brytyjskie ministerstwo obrony definicją sztuczna inteligencja to:

„(…) grupa uniwersalnych technologii, z których każda może umożliwić maszynom wykonywanie zadań, które normalnie wymagają ludzkiej lub biologicznej inteligencji, zwłaszcza gdy maszyny uczą się, jak te zadania wykonywać na podstawie danych.” – tłum. moje. MS

Proceed with Caution: Artificial Intelligence in Weapon Systems

Chapter 1: INTRODUCTION, str. 9

Raport podaje następujące cechy systemów uzbrojenia używających sztucznej inteligencij:

- Autonomia: taki system uzbrojenia potrafi przeprowadzić działanie bez udziału człowieka lub z małym udziałem. Począwszy od identyfikacji celu, przez namierzenie aż po oddziaływanie (engagement). Nie musi chodzić o strzelanie, ale też o np. automatyczne zagłuszanie, oślepianie systemów przeciwnika itd. – ms

- Adaptacja: użycie technologii AI pozwala systemom namierzać, śledzić, wybierać i atakować cele, które nie zostały wcześniej ściśle opisane w fazie programowania, ale które odpowiadają szerokiej definicji celów a system dzięki zdolności uczenia jest w stanie adaptować swoje działanie w nowej sytuacji.

- Szerszy zakres użycia: zgodnie z powyższym takie systemy uzbrojenia nie są projektowane do użycia względem jednego celu, ale umieją działać wobec typów celów lub kategorii celów. Rakiety przeciwlotnicze, przeciw innym rakietom itd – ms.

Zgodnie z tym takie systemy uzbrojenia raport nazywa AWS – Autonomous Weapon Systems.

Autonomous weapon systems (AWS) to systemy uzbrojenia, które potrafią namierzyć, wybrać i oddziaływać z małym lub żadnym udziałem człowieka lub wręcz posiadają jakiś stopień autonomii w jednym lub w wielu aspektach. Zakres autonomiczności, w jakim działają te systemy, może się znacznie różnić w danym przypadku. Począwszy od w pełni autonomicznych systemów a skończywszy a na systemach częściowo automatycznych, które wymagają ludzkiej decyzji o ataku. – tłum. moje. MS.

Proceed with Caution: Artificial Intelligence in Weapon Systems

Chapter 1: INTRODUCTION, str. 10

Technologia AI w wojskowości często jest objęta tajemnicą i w związku z tym raport podaje szereg prawdopodobnych przykładów użycia sztucznej inteligencji, bez podawania jej dokładnych cech czy możliwości. Są to np.:

- Naval Strike Missile (USA): pocisk firmy Raytheon, morska rakieta używająca sztucznej inteligencji w celu poprawy obrony przed atakami poza horyzontem (poza krzywizną Ziemi). Ma zasięg ponad 100 mil morskich i po wystrzeleniu prawdopodobnie jest zupełnie autonomiczna.

- Brimstone: pocisk europejski, produkowany przez firmę MBDA (Airbus, BAE, Leonardo). Może zostać zaprogramowany do wyszukiwania, identyfikowania, śledzenia i niszczenia celów na podstawie danych z jego sensorów.

- Boeing MQ-28A Ghost Bat: protypowy, bezzałogowy aparat latający, wdrażany przez firmę Boeing i RAAF (Królewskie Siły Powietrzne Australii). Miałby lecieć obok samolotu pilotowanego przez ludzi i używać sztucznej inteligencji do współdziałania. W tej chwili realizuje zadania z zakresu zwiadu, monitorowania i wczesnego ostrzegania. Do służby ma wejść w latach 2024-2025.

- Robotic Combat Vehicle-Light (USA): autonomiczny pojazd lekko opancerzony, zaprojektowany do działań razem z pojazdami kierowanymi przez ludzi. Testowany w roku 2022 może działać zupełnie niezależnie, pół-niezależnie albo zdalnie sterowany. Armia amerykańska chciała, żeby jeden operator mógł sterować wieloma takimi pojazdami. Prototyp uzbrojony był w działko 25 mm na zdalnie sterowanej wieży, ale też inne systemy uzbrojenia – granatnik 40 mm. Armia amerykańska chce przetestować całą gamę takich pojazdów (Robotic Combat Vehicles – RCV’s). Poniżej obrazek przedstawiający takie roboty wojenne – przepraszam za jakość, ale taka była w oryginale.

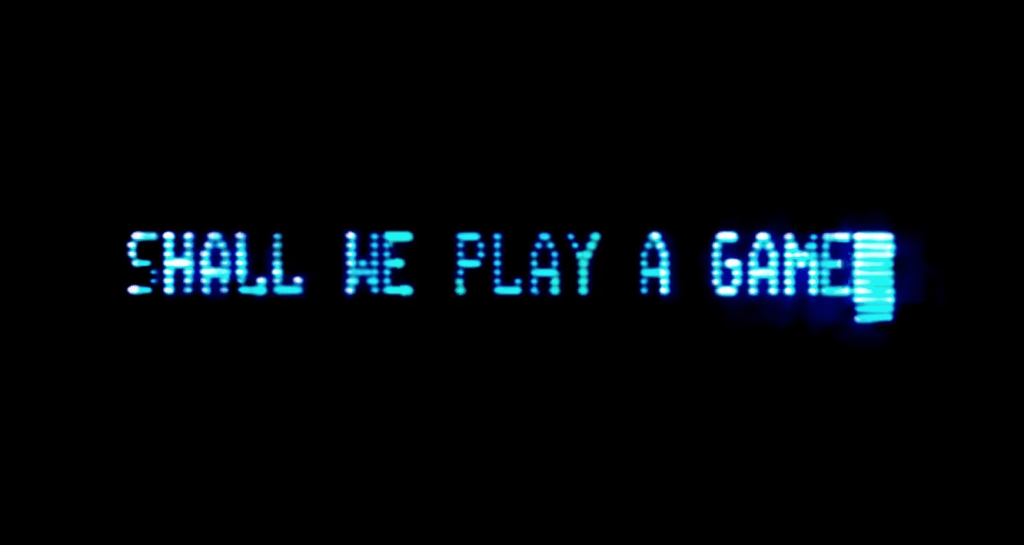

Raport podkreśla, że w niektórych obszarach obronności wprowadzenie AI jest wyjątkowo ryzykowne. Takim obszarem jest system kontroli nad bronią atomową. Mnie w tym momencie od razu przypomniał się od razu film „Gry Wojenne” (1983), który opowiadał o tym, jak młody haker przez pomyłkę połączył się komputerem sterującym rakietami atomowymi w USA i rozpoczął z nim grę, w której komputer w pewnym momencie uznał, że musi odpalić głowice. Wg raportu Izby Lordów jeszcze nam to nie grozi. Sztuczna inteligencja nie używa broni atomowej a w USA złożone został projekt ustawy zakazującej tego w przyszłości.

Ryzyko mogłoby wynikać z błędu ludzkiego, gdy ludzie niewłaściwie interpretują sygnały ze strony sztucznej inteligencji lub jeśli sztuczna inteligencja nieprawidłowo zinterpretuje sytuację. Jednocześnie wprowadzanie sztucznej inteligencji do tego obszaru powinno zostać odłożone do czasu, aż uda się zrozumieć działanie sztucznej inteligencji w większym stopniu („until a greater understanding of how to build reliable AI systems and their internal functions is gleaned”).

Przy tej okazji warto wspomnieć o wątku infekowania lub zniekształcania danych, na podstawie których uczy się sztuczna inteligencja. To szczególnie istotny, dość nowy kierunek analizy zagrożeń. Można znacznie osłabić skuteczność sztucznej inteligencji przeciwnika, jeśli na etapie tworzenia modeli dane zostaną celowo zniekształcone. Zniekształcenia i tak są ważnym problemem, bo sprawiają np., że system powtarza a czasem nawet wyolbrzymia błędy, które popełniają ludzie. Jeśli jednak mielibyśmy z celowym „zatruwaniem” danych, to sytuacja staje się bardziej skomplikowana. Przeciwdziałanie temu zagrożeniu m.in oznaczać może wzrost kosztów powstawania modeli sztucznej inteligencji wojskowej, bo dane będą musiały być izolowane, każdorazowo tworzone od podstaw, skrupulatnie analizowane.